清华北大等推出LLaVA-o1: 让视觉语言模型逐步推理

发布时间:2024-11-25正如 OpenAI 的 o1 等模型所展示的那样,大语言模型(LLM)在推理能力方面取得了长足进步,特别是通过推理时(inference-time)扩展。然而,当前的视觉语言模型(VLM)在执行系统化和结构化推理方面往往表现不佳,尤其是在处理复杂的视觉问答任务时。

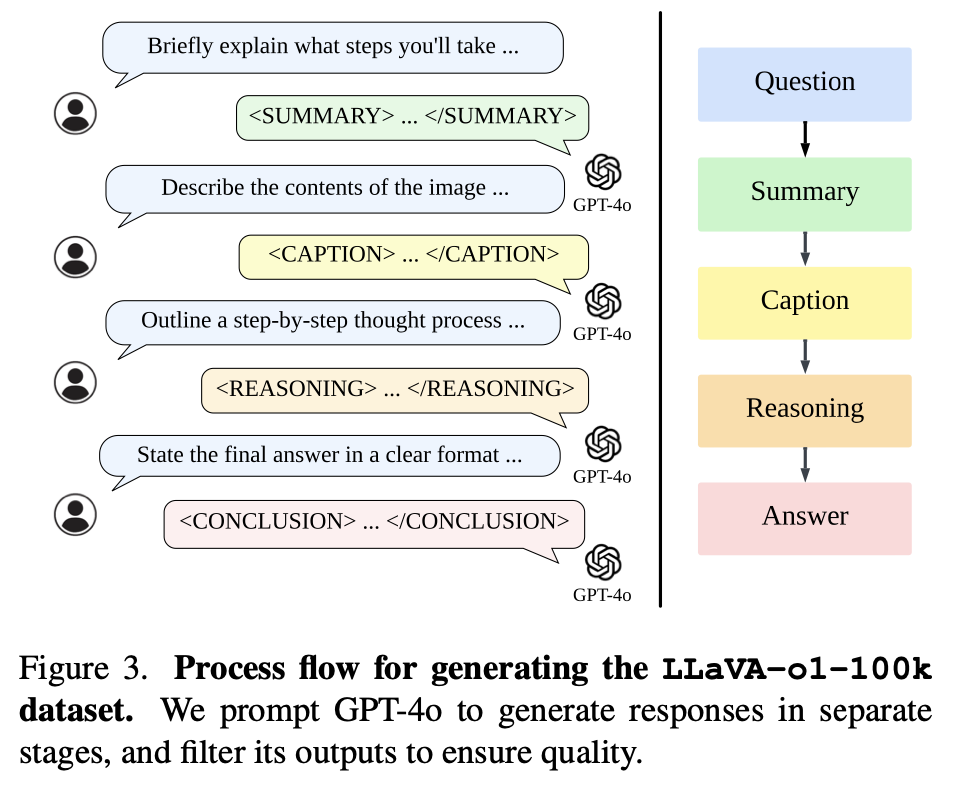

在这项工作中,来自北京大学、清华大学的研究团队及其合作者,提出了用于进行自主多阶段推理的视觉语言模型——LLaVA-o1。与思维链提示不同,LLaVA-o1 可独立完成总结、视觉解读、逻辑推理和结论生成等连续阶段。这种结构化方法使 LLaVA-o1 在推理密集型任务中的精确度得到显著提高。

为实现这一目标,他们编译了 LLaVA-o1-100k 数据集,整合了来自各种视觉问答来源的样本,并提供了结构化推理注释。此外,他们还提出了一种推理时阶段级波束搜索方法,从而实现了有效的推理时扩展。值得注意的是,LLaVA-o1 仅用了 100k 个训练样本和一种简单有效的推理时扩展方法,不仅在广泛的多模态推理基准上比其基础模型高出 8.9%,而且还超过了更大闭源模型的性能,如 Gemini-1.5-pro、GPT-4o-mini 和 Llama-3.2-90B-Vision-Instruct。

论文链接:https://arxiv.org/abs/2411.10440

来源:学术头条